Para poder trabajar de forma correcta, un porcentaje elevado de los algoritmos de inteligencia artificial (IA) requieren de una fase previa denominada de aprendizaje.

En ella, se utiliza información disponible para entrenar a los algoritmos para realizar una tarea concreta.

Por ejemplo, en el ámbito de la detección temprana de cáncer, una tarea podría ser que el algoritmo, al analizar una prueba de diagnóstico por imagen (TAC, ecografía, resonancia magnética, radiografía) conjuntamente con datos del paciente (demográficos, precedentes médicos, historial familiar, etc.), sea capaz de indicar si se trata de un tumor potencialmente maligno o no.

Para ello, en la fase de entrenamiento, se le muestra el conjunto de datos y pruebas diagnósticas de diferentes pacientes indicando en cada caso de qué tipo de tumoración se trata.

De esta forma, debería ser capaz, una vez entrenado, de identificar aquellos parámetros, tanto del historial como de las imágenes diagnósticas, que apuntan hacia una patología. Uno de los factores clave es que el algoritmo se haya entrenado con un amplio abanico de casuísticas.

Wikimedia Commons, CC BY

Tradicionalmente, las etapas de entrenamiento se solían realizar recogiendo información de diferentes pacientes que era enviada a un servidor central. Este se ocupaba de almacenarla y entrenar al sistema de IA.

Una vez entrenado, desde el centro médico se enviarían los datos de un nuevo paciente al servidor para preguntar al algoritmo por su valoración y, tras esperar por la respuesta, esta sería remitida de nuevo al centro médico de origen.

El problema de los datos sensibles

Seguro que, al leer este proceso, ya habrá percibido uno de los inconvenientes de los sistemas de aprendizaje centralizados: la privacidad de la información.

En un tema tan sensible como la salud, compartir datos confidenciales con terceros no parece una medida adecuada.

Esta no es la única debilidad de la aproximación centralizada. Hemos comentado que es importante entrenar al algoritmo con un conjunto variado y representativo de datos, esto conlleva un volumen muy elevado de información que es preciso recoger, almacenar y tratar.

Además, el tiempo de espera desde que se envía la solicitud de valoración al algoritmo hasta que es recibida podría afectar al procedimiento médico, como en el caso de un accidente cardiovascular, donde los tiempos de reacción son clave.

Con el objetivo de solventar estas tres dificultades — garantías de privacidad, gestión de grandes volúmenes de información y tiempos de respuesta del algoritmo—, surge un nuevo paradigma denominado aprendizaje federado (AF).

Coordinar y distribuir el trabajo

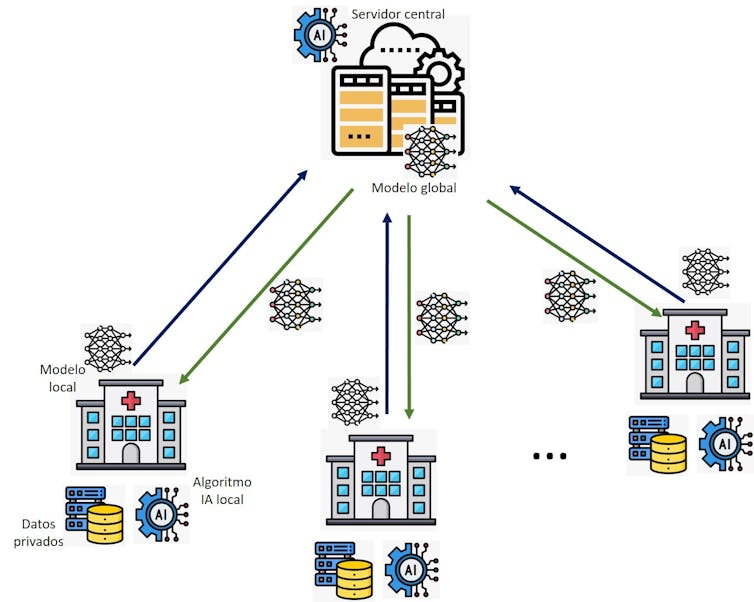

En un sistema de AF, la inteligencia artificial no se entrena y ejecuta en un único servidor central, sino de forma cooperativa entre un conjunto de elementos que son los poseedores de los datos y se ejecuta de forma individual y local en cada uno de ellos.

En nuestro ejemplo médico, los elementos que colaboran en el proceso de aprendizaje serían los diferentes sistemas de salud que quieren trabajar de forma coordinada. Cada uno de ellos custodia y mantiene los datos de sus pacientes, que no son compartidos bajo ningún concepto.

Estos datos se usan para entrenar el mismo algoritmo de detección temprana de cáncer. Habrá tantos algoritmos ejecutándose como sistemas de salud participen en la red de AF.

Rebeca P. Díaz a partir de iconos de Flaticon.es.

¿Cómo se consigue entonces la colaboración entre ellos sin compartir los datos confidenciales? La clave es que, en lugar de compartir los datos médicos de los pacientes, se comparte un resumen de lo aprendido con dichos datos médicos.

En términos más técnicos, este resumen sería el conjunto de parámetros que caracteriza al sistema de IA (también denominado modelo del algoritmo).

Estos parámetros van variando de valor a medida que avanza el proceso de aprendizaje, adaptándose a los datos con los que ha sido entrenado el algoritmo. Por lo tanto, el resumen establece una visión local: aquella formada por los pacientes de ese sistema de salud.

De forma periódica, los resúmenes locales son enviados a un servidor central que se ocupa de conjugarlos en un nuevo resumen o modelo, pero esta vez global, dado que ha aprendido de los datos de pacientes de diferentes sistemas de salud.

Dicho modelo global es enviado de vuelta y, en cada sistema de salud, se combinará con el local para crear un modelo enriquecido que ha aprendido de los datos propios y de los ajenos.

Este paradigma, además de mitigar los riesgos de privacidad, ofrece una solución a la escalabilidad, dado que no es preciso gestionar volúmenes tan elevados de datos como en el aprendizaje tradicional.

Además, es posible agregar nuevas fuentes de información y aprendizaje mediante la adición de nuevos elementos de cómputo locales –sistemas de salud en nuestro ejemplo–. Esto es importante para mejorar la diversidad de los datos y evitar sesgos en los resultados.

Por último, se consigue una ejecución más ágil que no depende de tiempos de latencia en las comunicaciones, dado que la consulta al algoritmo no se hace al servidor central, sino al propio sistema de salud.

Retos del aprendizaje federado

Una de las vías a explorar es la evolución hacia el aprendizaje descentralizado, donde ya no existe este elemento agregador central.

En su lugar, los diferentes elementos que ejecutan los algoritmos de IA comparten entre sí directamente el conocimiento adquirido o resumen.

Brigadier Lance Mans, NATO Special Operations Coordination Centre, CC BY

Esto facilita la agilidad en entornos en movilidad: como los sistemas de visión artificial en redes de drones o los sistemas de conducción autónomos.

Por otra parte, y aunque se ha mencionado que esta tecnología mitiga los riesgos de privacidad, es importante destacar que no los evita por completo.

En este sentido, hay investigaciones en curso que tratan de proteger las redes de AF de ataques que traten de alterar de manera intencionada el modelo global o inferir información confidencial a través del análisis de los modelos que se comparten.

Rebeca P. Díaz Redondo, Catedrática de Universidad en el área de ingeniería telemática. atlanTTic (Research center for Telecommunication Technologies), Information & Computing Lab. Escola de Enxeñaría de Telecomunicación, Universidade de Vigo

Este artículo fue publicado originalmente en The Conversation. Lea el original.

--

--